22 Verschwörungstheorien im Podcast – Ein Praxisbericht

Thomas Stelzl

Abstract

2022 produzierte Skill.de-Mitarbeiter Thomas Stelzl im Rahmen des Teilprojekts Geschichtsdidaktik den Podcast “Sie sind unter uns”. Dieser beschäftigt sich mit Verschwörungstheorien in Gegenwart und Vergangenheit, besonders in Deutschland und den USA. Dabei werden konkrete Beispiele wie QAnon, die angeblichen ‚Protokolle der Weisen von Zion‘ oder die Reichsbürgerbewegung ebenso angesprochen wie die Rolle der Medien und der Wissenschaftsleugnung. Der Podcast richtet sich an Studierende, die noch nicht vertieft mit dem Thema vertraut sind, sowie an Schülerinnen und Schüler der Oberstufe und die interessierte Öffentlichkeit. Er wurde im Sommersemester 2022 im Rahmen des Proseminars „CUI BONO? Ein Seminar über Verschwörungstheorien“ erprobt und evaluiert. Außerdem wurde in Zusammenarbeit mit den Kursteilnehmenden Begleitmaterial produziert.

Im folgenden Video Berichten Thomas Stelzl und Andreas Michler von den Praxiserfahrungen, die sie im Rahmen dieses Projekts machen konnten. Dabei kommen auch Studierende zu Wort. Anschließend werden die in Zusammenarbeit mit Sima Caspari-Sadeghi gewonnenen Evaluationsergebnisse präsentiert. Ebenfalls angegeben sind Links zur Website des Podcasts, auf der alle Materialien frei heruntergeladen werden können.

Verschwörungstheorien im Podcast_pdf

|

SIE SIND UNTER UNS. Ein Podcast über Verschwörungstheorien ist zusammen mit allen Zusatzmaterialien abrufbar unter: https://blog.dilab.uni-passau.de/sie-sind |

Evidenzbasierte Evaluation des Podcasts durch Aktionsforschung

Der nachfolgende Text entstand in Zusammenarbeit von Sima Caspari-Sadeghi (Coachin) und Thomas Stelzl (Forscher), die die Evaluation gemeinsam durchgeführt haben.

Um die Effektivität des Einsatzes digitaler Medien (z. B. Podcasts) in der Geschichtsdidaktik zu untersuchen, entschieden wir uns für Aktionsforschung (Action Research – AR), um empirische Daten darüber zu sammeln, wie die Teilnehmenden/Studierenden den digital unterstützten Unterricht wahrnehmen. AR ist eine geeignete Forschungsmethode, um gleichzeitig Forschung im Seminarraum durchzuführen und die Ergebnisse solcher Studien zur Verbesserung des zukünftigen Medieneinsatzes zu nutzen. Sie besteht aus 5 Phasen, nämlich (1) Planung, (2) Instrumentenentwicklung, (3) Datenerhebung, (4) Datenanalyse und (5) Reflexion und Aktion. Das AR-Team bestand aus einem forschenden Dozenten (genannt Forscher) und einer Evaluationscoachin (genannt Coachin).

Im Folgenden werden die einzelnen Phasen im Detail beschrieben.

Phase 1: Planung

Der erste Schritt bestand darin, den Forschungsschwerpunkt der Untersuchung festzulegen. Das AR-Team traf sich regelmäßig online, um sowohl Struktur und Ziele als auch die Herausforderungen des Lehrbetriebs zu besprechen. Sie identifizierten ein Problem:

- Forschungsproblem: Der Dozent entwarf Podcasts und bat um Feedback zur Verbesserung seines Podcasts durch eine Online-Umfrage. Die Beteiligung an den Umfragen ging im Laufe des Semesters jedoch so weit zurück, dass dort zuletzt nur noch vereinzelte Studierende ihr Feedback gaben.

In Anbetracht der Bedeutung digitaler Medien für das Lehren und Lernen wurde beschlossen, die Qualität der Podcasts in den Mittelpunkt der Evaluation zu stellen.

- Forschungsziel 1: aktive und sinnvolle Einbeziehung der Studierenden, um objektives Feedback zu erhalten (Feedback-Kompetenz),

- Forschungsziel 2: Nutzung von Feedback und Kommentaren zur Verbesserung des Bewertungsschemas für spätere Anwendungen.

Phase 2: Instrumentenentwicklung

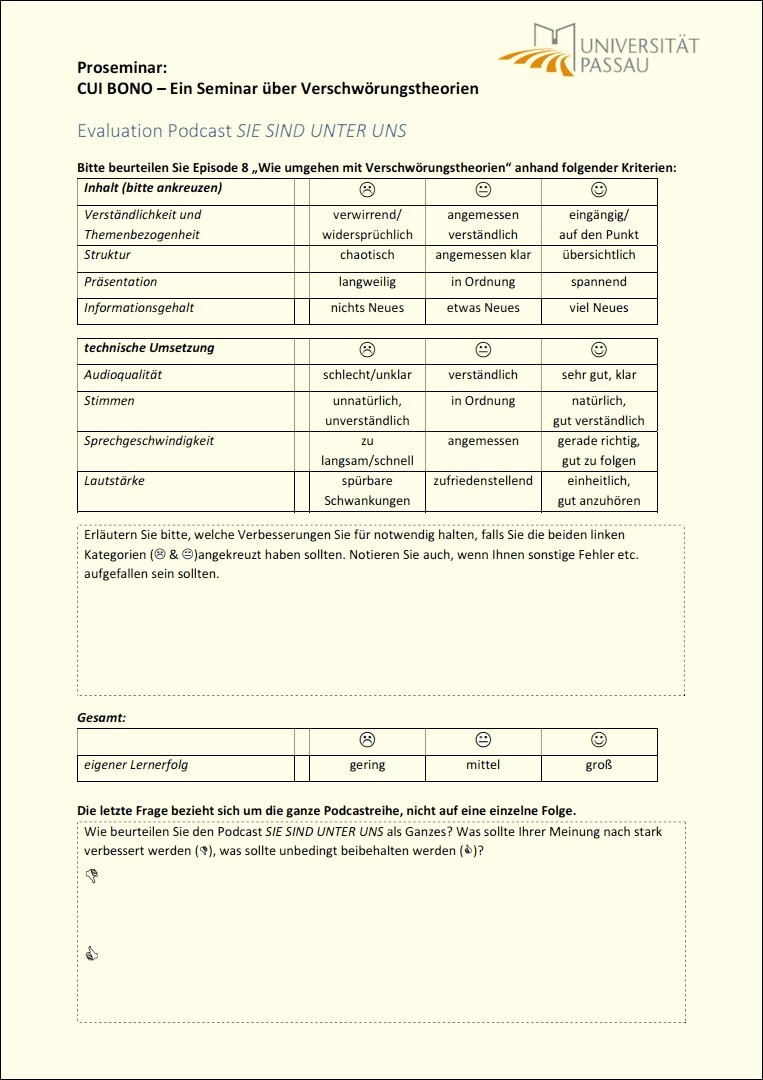

Bewertungsschemata, die aus einer Reihe von Standards/Kriterien, Deskriptoren und einer Bewertungsskala bestehen, sind gängige Instrumente zur Bewertung der Qualität eines Podcasts. Zunächst erhielt der Forscher eine eingehende Schulung zur Gestaltung eines Bewertungsschemas. Ziel war es, sicherzustellen, dass der Forscher in der Lage ist, ein Schema zu entwerfen oder zu modifizieren. Wir untersuchten einige validierte Bewertungsschemata für Podcasts, übernahmen einige relevante Items und Fragen, entwarfen einige neue Items und überarbeiteten diese zuletzt nach den Grundsätzen und Standards eines guten Bewertungsschemas. So sollte z. B. durch die Reduzierung der Antwortmöglichkeiten von 5 (sehr gut, gut, mittel, schlecht, sehr schlecht) auf 3 (gut-mittel-schlecht) „kognitive Überforderung“ vermieden werden (vgl. gelber Evaluationsbogen, Abbildung 1).

Phase 3: Datenerhebung

Die Daten wurden aus verschiedenen Quellen gesammelt, z. B. aus Evaluationsbögen, die (a) von den einzelnen Studierenden, (b) von den Studierenden als Gruppe und (c) von zwei unabhängigen Professoren ausgefüllt wurden. Eine weitere Datenquelle waren strukturierte Beobachtungen vor Ort durch (d) eine studentische Hilfskraft, die für die Erhebung relevanter Daten während der Durchführungsphase geschult wurde.

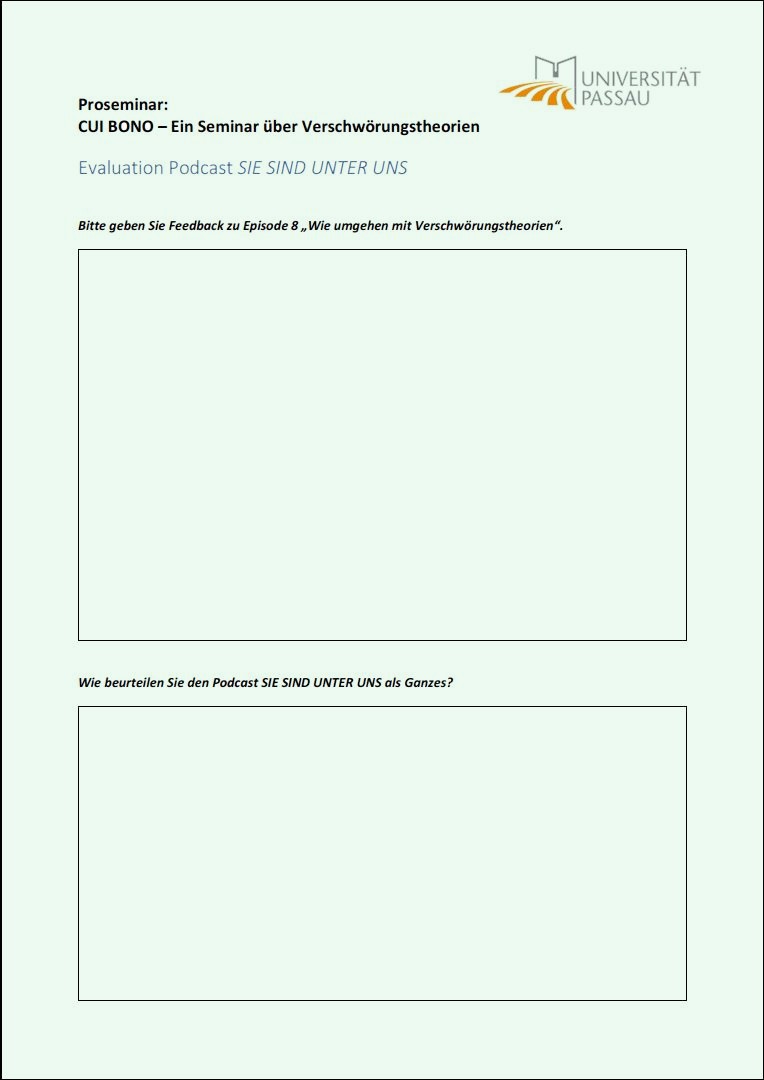

Die Studierenden wurden in zwei Gruppen eingeteilt: (a) die Versuchsgruppe (VG) und (b) die Kontrollgruppe (KG). Die Studierenden der VG erhielten das objektive, vom Dozenten erstellte Bewertungsschema (vgl. Abbildung 1, gelber Evaluationsbogen). Sie füllten die Evaluationsbögen zunächst individuell aus und wurden später angewiesen, einen weiteren, identischen Evaluationsbogen zusammen als Gruppe auszufüllen. KG hingegen erhielt ein grünes Evaluationsblatt ohne vorgegebenes Bewertungsschema (vgl. Abbildung 2). Auch die Studierenden der KG füllten zunächst individuell und später noch einmal als Gruppe den grünen Evaluationsbogen aus. Ziel war es, herauszufinden, auf welche Aspekte eines Produkts (z. B. eines Podcasts) sich die Studierenden in Ihrer Qualitätsbeurteilung konzentrieren, wenn ihnen keine objektiven Bewertungskriterien oder ‑Standards zur Verfügung stehen.

Phase 4: Datenanalyse

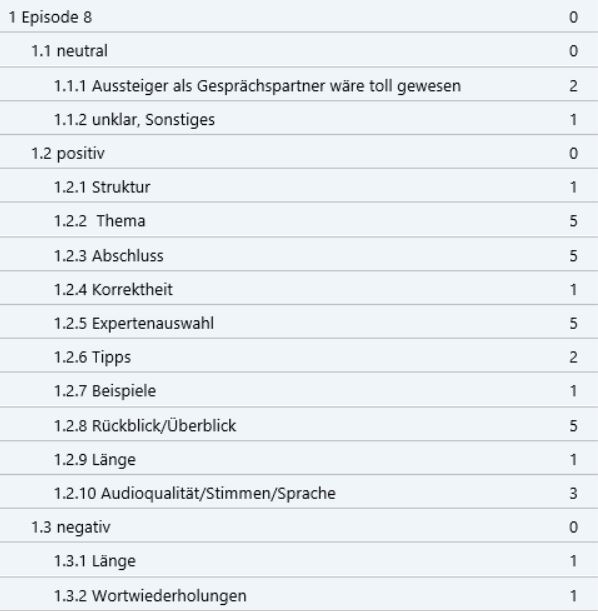

Für eine qualitative Inhaltsanalyse der offenen Antworten (grüne Evaluationsbögen, Abbildung 2) wurde die Software MAXQDA eingesetzt. Wir überprüften auch die Häufigkeit der Antworten auf die geschlossenen Fragen. Zunächst kodierten der Forscher und die Coachin die Daten unabhängig voneinander. Der Forscher verwendete einen deduktiven Kodierungsansatz (basierend auf den Kategorien des Bewertungsschemas), während die Coachin eine induktive, offene Kodierung verwendete. Wir diskutierten die Codes, optimierten diese (durch Zusammenführen und Reduzieren) und einigten uns darauf, die Bezeichnungen einiger Codes zu ändern (siehe Abbildungen 3a+b). Schließlich überprüften wir die Daten (sowohl von den Studierenden als auch von den Professoren) auf der Grundlage dieses vereinbarten Kodierungsschemas.

Im Folgenden fassen wir die Ergebnisse zusammen:

- Die Mehrheit der Studierenden und Professoren bewertete die Qualität des Podcasts als „ausgezeichnet“, nur wenige Aspekte wurden mit „gut/befriedigend“ bewertet.

- Es gab beträchtliche Überschneidungen zwischen den Rückmeldungen der Studierenden in der KG und denen der VG. Das bedeutet, dass sich die Studierenden, auch wenn ihnen keine Standards/Kriterien vorgegeben wurden, an den meisten der im Bewertungsschema eingebetteten Bewertungskriterien orientierten (z. B. „Struktur“, „Präsentation“, „Audioqualität“ usw.).

- Obwohl es Übereinstimmungen zwischen den vom Forscher erstellten Bewertungskriterien und dem Feedback der Studierenden aus der KG und denen der VG gab, wurden einige Kriterien, die im Bewertungsschema (gelber Evaluationsbogen, Abbildung 1) erwähnt wurden, entweder (a) ignoriert, d. h. sie tauchten im Feedback der Studierenden nicht auf (z. B. „Inhalt: Verständlichkeit und Themenbezogenheit“ oder „Technische Umsetzung: Lautstärke“), (b) von den Studierenden anders formuliert wurden (statt „Informationsgehalt“ wurden Begriffe wie „Thema/Input/Folge“, „Tipp“, „Beispiel“ verwendet), oder (c) widersprüchlich beantwortet wurden („Stimme“ oder „Länge“ wurden von einigen Studierenden positiv bewertet, von anderen aber als Schwachpunkte angesehen).

- Entgegen den Erwartungen entpuppte sich das Feedback der KG auf den offenen Evaluationsbögen (grün, Abbildung 2) als ergiebiger als das der VG. Dies lag wohl hauptsächlich daran, dass die Studierenden der KG zum einen nicht durch einen Kriterienkatalog auf bestimmte Themen beschränkt waren und dass die Studierenden der VG (wohl auch motiviert durch die Aufgabenstellung) nur begrenzt Gebrauch von den Freitextfeldern machten.

Phase 5: Reflexion und Aktion

In dieser Phase reflektierte der forschende Dozent über den gesamten Prozess und die Ergebnisse der Aktionsforschung, um so sowohl den Podcast als auch das Evaluationsschema zu verbessern. Daraus ergeben sich folgende Erkenntnisse:

- Im Hinblick auf das in der Evaluation genutzte Bewertungsschema (Abbildung 1) sollten einige Veränderungen vorgenommen werden:

- Die Kategorie „Verständlichkeit und Themenbezogenheit“ sollte umbenannt und präzisiert werden, um für die Studierenden besser verständlich zu sein.

- Die Kategorie „Präsentation“ sollte besser erklärt und eventuell um ein Beispiel ergänzt werden.

- Die Kategorie „Informationsgehalt“ sollte anhand der von den Studierenden der KG genutzten Begriffe („Thema/Input/Folge“, „Tipp“, „Beispiel“) spezifiziert werden.

- Die Kategorie „Lautstärke“ sollte unter „Audioqualität“ subsumiert werden.

- Das Ausfüllen von Freitextfeldern ergänzend zum Ankreuzen des Bewertungsschemas sollte explizit ermuntert werden, statt es durch eine einschränkende Arbeitsanweisung („Erläutern Sie […] falls Sie die beiden linken Kategorien [ 🙂 & 🙁 ] angekreuzt haben sollten“) zu begrenzen.

- Komplexe Produkte, wie ein Podcast oder ein Seminar, lassen sich nur begrenzt über ein rein quantitatives Bewertungsschema abbilden. Dies wird verschärft dadurch, dass den Evaluationsteilnehmenden ohne eingehende Erläuterungen – welche allerdings Zeit kosten – der Hintergrund der einzelnen Frageitems nicht zwangsläufig bewusst ist. Andererseits schränkt ein vorgegebenes Bewertungsschema auch die Antwortmöglichkeiten der Evaluierenden ein, was zwar für eine einfachere Auswertung, aber weniger ergiebige Ergebnisse sorgt.

Als besonders wertvolle Ergänzung zum Datenmaterial wurden die Notizen einer studentischen Hilfskraft wahrgenommen, welche die Evaluierenden während deren Gruppendiskussionen (vgl. Phase 3) beobachtete. Mit ihrer Hilfe konnten einige der Gründe für die auf den Evaluationsbögen teils nur in Stichpunkten abgegebenen Bewertungen identifiziert werden.

- Insgesamt sind die Ergebnisse der Evaluation sehr positiv, einer Veröffentlichung des Podcasts steht von dieser Seite also nichts entgegen. Auf der Basis der Rückmeldungen der Studierenden wurden im Rahmen der Möglichkeiten einige Aspekte des Podcasts überarbeitet, wobei sich diese speziell auf die Korrektur von Fehlern bezog. Vorgelagerte Feedbackrunden zu Beginn der Produktion hatten jedoch bereits zur Weiterentwicklung des Formats beigetragen (so wurde etwa auf studentisches Feedback hin zu Beginn jeder Folge ein kurzer, strukturierender Überblick über Gäste und Themen eingefügt).

- Eine fortlaufende Qualitätssicherung der Podcast-Folgen vor der Veröffentlichung ist nötig und wurde im Falle des hier behandelten Podcasts „Sie sind unter uns“ bereits im Semesterverlauf durch Diskussionen im Seminarraum, die unter „Forschungsproblem“ erwähnten Online-Umfragen sowie „Testhören“ durch Kolleg:innen sichergestellt. So konnte auch früh in der Produktion Feedback aufgegriffen und die Gestaltung der Podcast-Folgen entsprechend verbessert werden.

Im Hinblick auf die hier beschriebene, aufwändige Aktionsforschung würde es sich empfehlen, diese nicht erst gegen Ende, sondern bereits zu Beginn der Medienproduktion (etwa nach Fertigstellung von 1-2 Pilotfolgen) durchzuführen. Dies würde die Möglichkeit eröffnen, auch dieses umfangreiche Feedback in der Gestaltung einer laufenden Produktion stärker zu berücksichtigen als dies in einer nachträglichen Überarbeitung möglich ist. Zudem könnte ein im Rahmen einer frühen Evaluation durch Aktionsforschung weiterentwickeltes Bewertungsschema auch schnell und einfach in einer Abschlussevaluation wieder herangezogen werden.

Medien-Attributierungen

- podcast_grafik © Pixabay-Lizenz

- Abbildung 1: Evaluationsbogen mit vorgegebenem Bewertungsschema © Thomas Stelzl is licensed under a CC BY (Namensnennung) license

- Abbildung 2: Evaluationsbogen ohne vorgegebenes Bewertungsschema © Thomas Stelzl is licensed under a CC BY (Namensnennung) license

- Abbildung 3a: Die Analyse der offenen Antworten (grüne Evaluationsbögen) ergab das abgebildete Codesystem, die Zahl zeigt, wie häufig der Code genannt wurde. 3a bezieht sich auf die Antworten der Studierenden in Bezug auf Podcast-Folge 8 (Frage 1 auf dem grünen Evaluationsbogen) © Thomas Stelzl is licensed under a CC BY (Namensnennung) license

- Abbildung 3b bezieht sich auf den Podcast als Ganzes (Frage 2 auf dem grünen Evaluationsbogen) © Thomas Stelzl is licensed under a CC BY (Namensnennung) license